TECNOLOGIA | 06.05.2020

Uma interface cérebro-computador que funciona “traduzindo” nossos pensamentos

Microsiervos

Há muito trabalho em andamento para criar interfaces cérebro-computador que nos permitam “ler” nossos pensamentos ou, mais precisamente, as palavras ou imagens nas quais nos concentramos e queremos transmitir em um momento específico. Isso teria implicações muito importantes quando se trata de simplificar os comandos com os quais podemos interagir com todos os tipos de dispositivos: comandos simples, transmissão de mensagens ou respostas rápidas.

Agora, uma equipe de neurocientistas do Centro de Neurociências da UCSF (EUA) publicou na revista Nature Neuroscience um artigo intitulado “Tradução automática da atividade cortical em texto com uma estrutura de decodificação de código” que tem a ver precisamente com isso. Por trás desses termos técnicos complicados, existe algo que pode ser explicado de maneira mais simples: o que eles fizeram foi usar técnicas já conhecidas, como traduções de textos entre diferentes idiomas, para tentar “traduzir” esses sinais do cérebro em textos comuns. Em outras palavras: a inteligência artificial que usamos para traduzir do alemão para o inglês também pode ser usada para traduzir da “linguagem dos pensamentos” para o inglês.

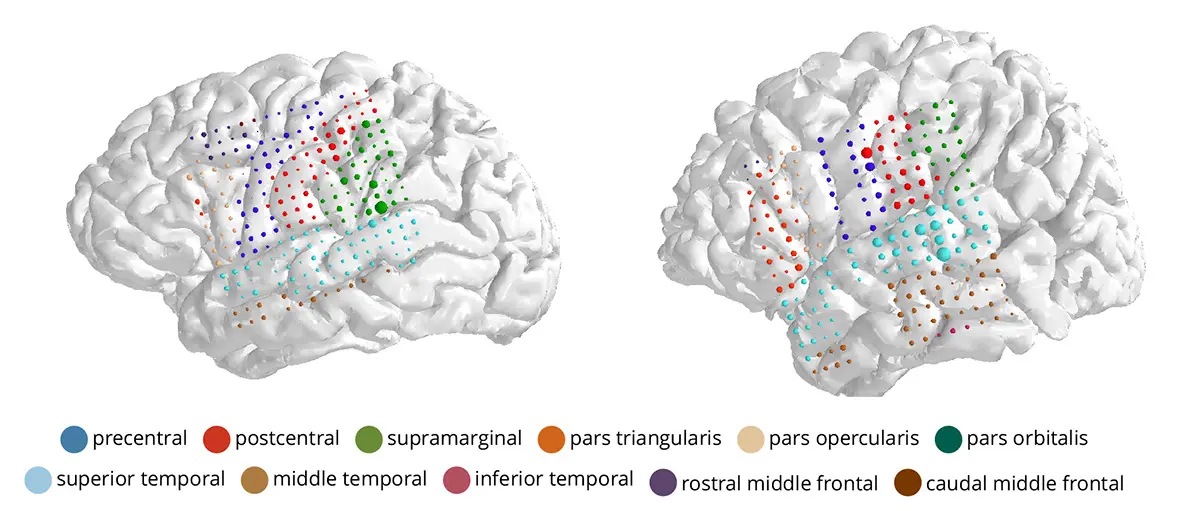

Ao contrário de outros sistemas parecidos, este usa um eletrocorticograma que registra sinais do cérebro por meio de cerca de 250 pequenos eletrodos implantados sob o crânio. Outros sistemas similares menos invasivos empregam um tipo de touca de natação da qual saem cabos (isso, ou algo semelhante a uma faixa de cabelo ou armação de óculos, seria o gadget ideal para conversar com computadores ou outras máquinas, como o carro do futuro). O sistema analisa a atividade desses sinais em busca de padrões reconhecíveis usando algoritmos semelhantes aos que analisam a voz ou as imagens de um filme.

Até agora, a conversão desses sinais em texto era realizada com precisão e velocidade muito menores que a conversão de fala em texto (que também utiliza técnicas típicas da inteligência artificial). O novo sistema deixa de lado a técnica tradicional de identificação de fonemas, com a qual se reconhecem as palavras, para se concentrar na identificação de frases completas e de palavras, como fazem os tradutores de texto em diferentes idiomas. Como certas palavras têm maior probabilidade estatística de aparecerem juntas, isso as ajuda a serem reconhecidas mais facilmente.

Diversas mulheres, que já haviam implantado eletrodos para monitorar crises epilépticas, se voluntariaram aos testes e foram separadas em grupos. Os sinais variam naturalmente de pessoa para pessoa e dependem também da região em que os eletrodos são implantados. O treinamento exigia somente meia hora. Consistia na leitura de 30 a 50 frases com 250 palavras diferentes: “a criança tem 4 anos“, “há várias crianças na sala“, “há quatro velas no bolo” e coisas do gênero. As frases também foram associadas a imagens em um dos grupos. Isso forneceu uma base para o sistema reconhecer a qual parte das frases pertenciam as palavras-chave: “criança”, “bolo”, “sala” e assim por diante.

O mesmo algoritmo foi alimentado com os eletrocorticogramas pela leitura de outras frases diferentes, para ver quantas palavras era possível identificar. O resultado mostrou uma precisão incomum, com apenas 7% de erros em metade das voluntárias, em comparação com outros sistemas similares, onde há entre 50 e 60% mais registros de erros.

Outra questão promissora dessa pesquisa é que, além de sua confiabilidade, o sistema foi extremamente flexível: nem todas as pessoas que leram as frases o fizeram corretamente, às vezes houve pausas, ruídos (como hmmm…) e sons similares, mas ainda assim o sistema conseguiu reconhecer corretamente as palavras-chave em seus contextos. Da mesma forma, nem as participantes tiveram os eletrodos implantados exatamente no mesmo local, mas o sistema e os cálculos que os algoritmos realizaram foram capazes de adaptar o que foi aprendido (as equivalências de frases e de palavras) de uma pessoa para a outra. Isso indicaria que esses algoritmos de aprendizado são capazes de “traduzir” as palavras nas quais a pessoa está pensando, não somente com precisão, mas também com flexibilidade, quase da mesma forma como somos capazes de reconhecer outros idiomas, de modo mais ou menos independente de quando estão falando conosco.