TECNOLOGÍA | 06.05.2020

Una interfaz cerebro-ordenador que funciona «traduciendo» lo que pensamos

Microsiervos

Mucho se está trabajando en la creación de interfaces cerebro-ordenador que permitan «leer» nuestros pensamientos o, más exactamente, las palabras o imágenes en las que nos concentramos y queremos transmitir en un momento dado. Esto tendría implicaciones importantísimas a la hora de simplificar los comandos con los que podemos interactuar con todo tipo de dispositivos: órdenes sencillas, transmisión de mensajes o respuestas rápidas.

Ahora un equipo de neurocientíficos del Centro de Neurociencias de la UCSF (EE.UU.) ha publicado en Nature Neuroscience un artículo titulado «Traducción automática de la actividad cortical a texto con un marco codificador-decodificador» que tiene que ver con esto. Tras estos complicados términos técnicos se esconde algo que se puede explicar de forma más sencilla: lo que han hecho es utilizar técnicas ya conocidas como las de las traducciones de textos entre distintos idiomas para intentar «traducir» esas señales del cerebro en textos normales y corrientes. Dicho de otra forma: la inteligencia artificial que usamos para traducir de alemán a inglés puede servir también para traducir del «idioma de los pensamientos» al inglés.

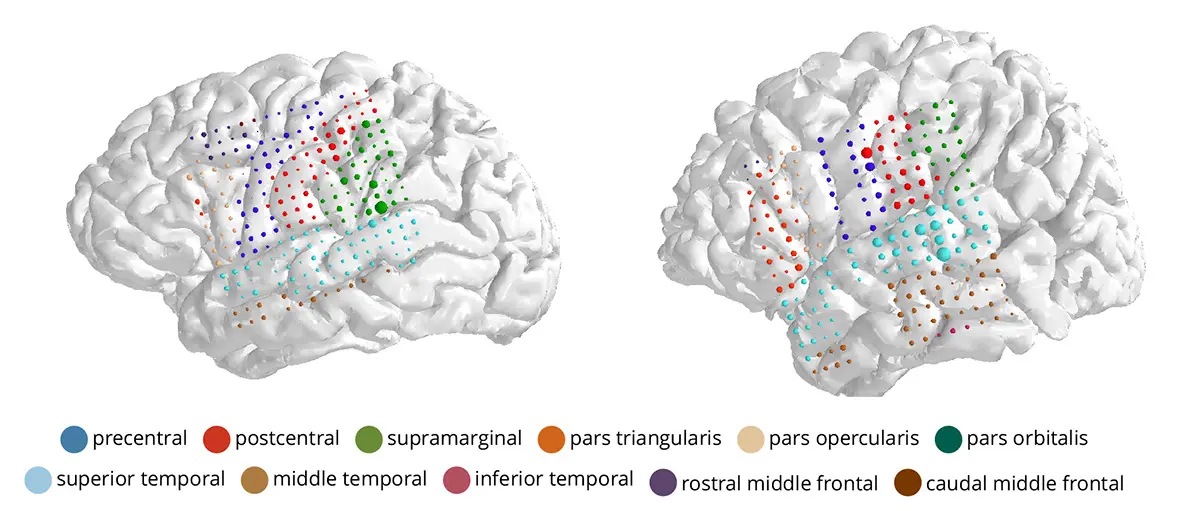

A diferencia de otros sistemas similares, en este se utiliza un electrocorticograma que graba las señales del cerebro mediante unos 250 pequeños electrodos implantados bajo el cráneo; otros sistemas similares menos invasivos emplean una especie de gorrito de natación del que salen cables (esto –o algo parecido a una diadema o la montura de unas gafas– sería lo ideal como gadget para hablar con los ordenadores u otras máquinas como el coche en el futuro.) El sistema analiza la actividad de esas señales en busca de patrones reconocibles mediante algoritmos similares a los que analizan la voz o las imágenes de una película.

Hasta ahora la conversión de estas señales a texto se realizaba con una precisión y una velocidad bastante más baja que la de la conversión de voz-a-texto (que también usa técnicas típicas de la inteligencia artificial). El nuevo sistema deja de lado la técnica tradicional de identificar fonemas con los que reconocer las palabras, para concentrarse en frases completas e identificar palabras, como hacen los traductores de texto entre distintos idiomas. Dado que ciertas palabras tienden a aparecer juntas con mayor probabilidad estadística, esto ayuda a reconocerlas más fácilmente.

A las pruebas se presentaron voluntarias varias mujeres que ya tenían implantados electrodos para monitorizar ataques epilépticos y fueron separadas en grupos. Las señales, naturalmente, varían de unas personas a otras y según donde estén implantados los electrodos. El entrenamiento tan sólo requirió media hora; consistió en la lectura de entre 30 y 50 frases con unas 250 palabras diferentes: «el niño tiene 4 años», «en la habitación hay varios niños», «hay cuatro velas en la tarta» y similares; en uno de los grupos se asociaban también frases y dibujos. De este modo se planteaba una base para que el sistema reconociera a qué parte de las frases pertenecían las palabras claves: «niño«, «tarta», «habitación», etcétera.

A continuación se alimentaba el mismo algoritmo con los electrocorticogramas procedentes de la lectura de otras frases distintas, para ver cuántas palabras podía identificar. El resultado mostraba una precisión inusual, con tan solo un 7% de errores en la mitad de las voluntarias, frente a otros sistemas similares donde hay un 50 o 60% de errores.

Otra de las cuestiones prometedoras de esta investigación es que además de su fiabilidad el sistema resultaba extremadamente flexible: no todas las personas que leían las frases lo hacían correctamente, a veces había pausas, ruidos (hmmm…) y similares, pero aun así el sistema era capaz de reconocer correctamente las palabras clave en su contexto. Del mismo modo, no todas ellas tenían implantados los electrodos exactamente en el mismo sitio, pero el sistema y los cálculos que realizan los algoritmos son capaces de adaptar lo aprendido (las equivalencias de frases y palabras) de unas personas a otras. Esto indicaría que estos algoritmos de aprendizaje pueden ser capaces de «traducir» las palabras en que está pensando la persona no sólo de forma precisa sino además flexible, casi del mismo modo que las personas somos capaces de reconocer otros idiomas más o menos independientemente quién nos esté hablando.